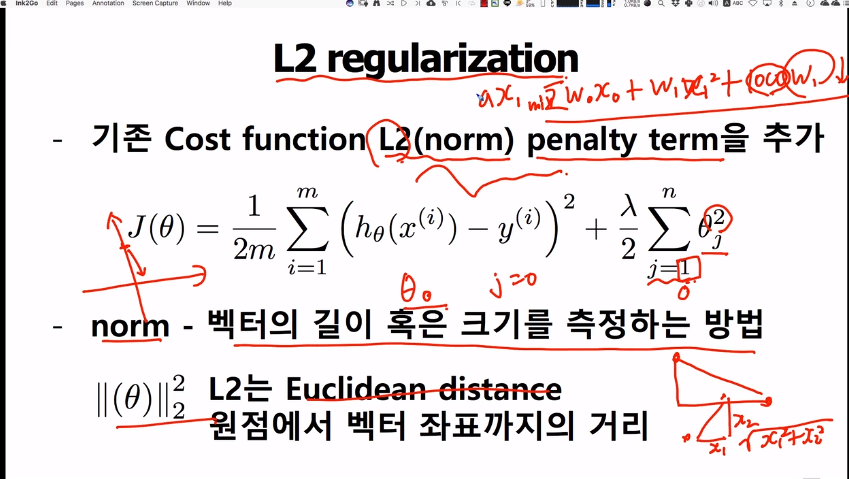

L2 regularization은 Ridge reregularization이라 불리고

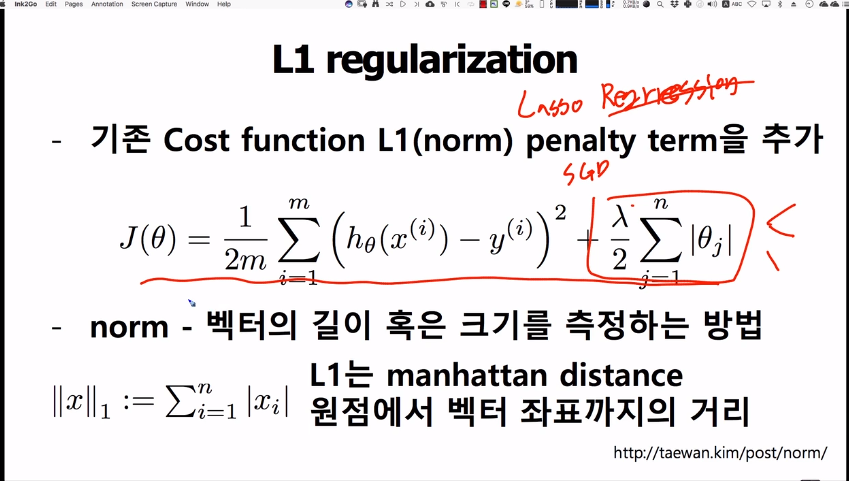

L1 regularization은 Lasso reregularization이라 불린다

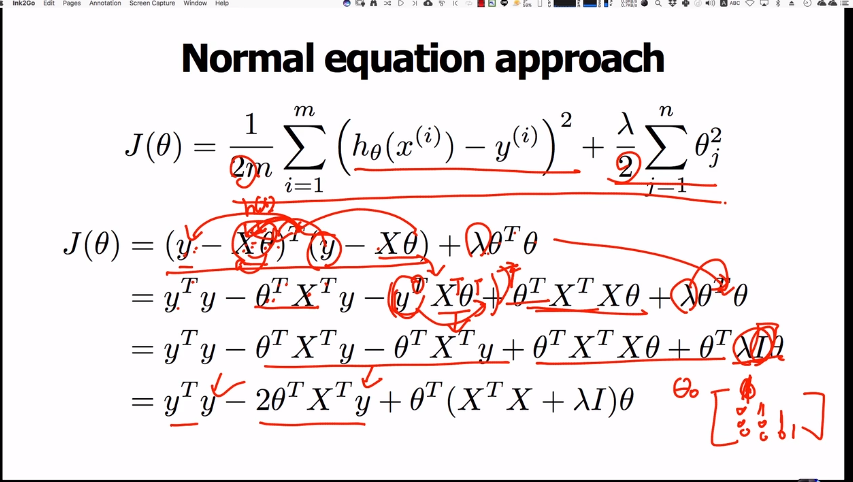

・위식을 보면 왜 regularization을 위해 추가적인 θ값을 붙였는지 이해할 수 있는데

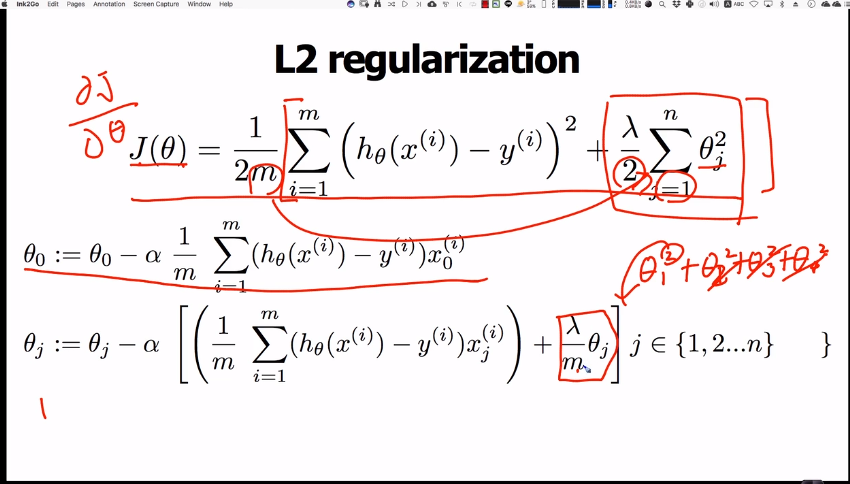

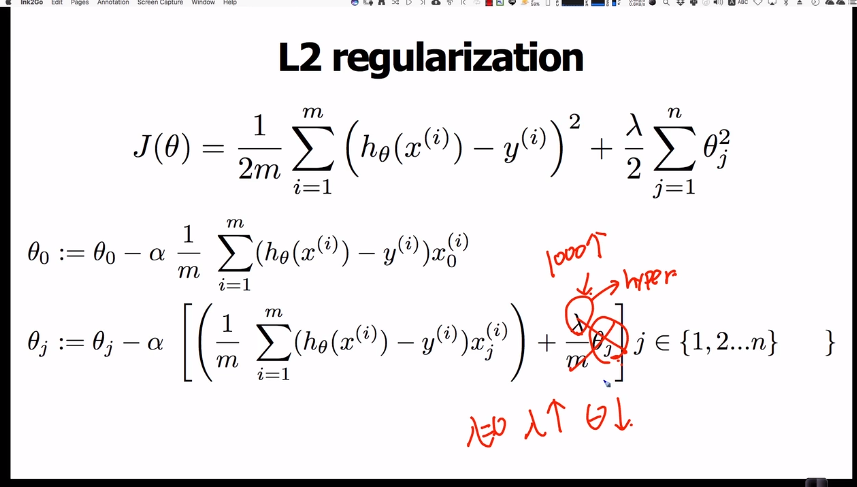

learning rate α < 1

the number of traing dataset m > 10

generally λ < m

이 되므로, λ가 커질 수록 θi값은 감소하게 된다.

・θi값이 작아지면 작아질 수록 변곡점이 평탄해지므로, θi값을 가능한한 작게 만드는 것이 regularization의 목적임을 잊지말자.

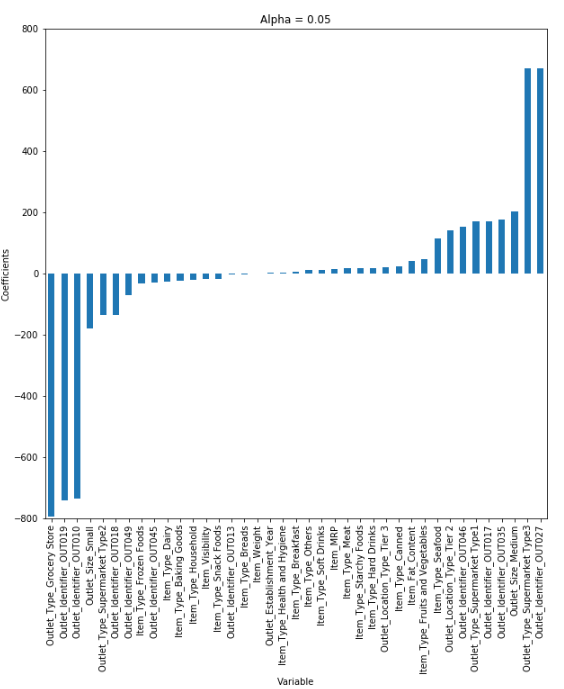

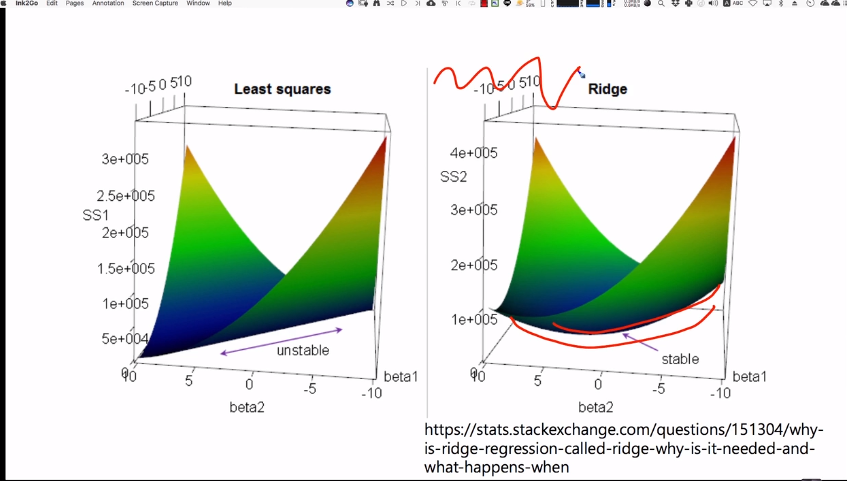

・위 그래프는 정규화가 필요한 이유와 그 효과를 설명하기 위한 그래프이다.

・Outlet_identifier_Out027과 Ouutlet_Type_Supermarket_Type3 feature의 계수가 다른 계수에 비해 월등히 큰것을 알 수 있는데, 이는 위의 두 계수에 의해 결과값이 널뛰기를 한다는 것을 의미한다. 따라서, 계수의 크기를 적당히 낮춰주어야할 필요성이 있다.

・alpha의 크기에 따라 계수의 크기가 줄어드는 것을 확인할 수 있다.

(https://brunch.co.kr/@itschloe1/11)

・L1은 절대값을 통한 regularization작업으로, 절대값은 미분을 실행함에 있어서 부가적인 작업이 필요하게 되므로 식 전개에 불편함이 따른다. 때문에 L2가 더 빈번히 이용된다.

・편의상 2개의 feature만 존재한다고 하면, L1과 L2는 위와 같이 그려질 수 있다. L1은 절대값 함수 이기 때문에, 마름모 모야의 그래프가 되고, L2는 제곱함수 이기 때문에 원모양의 그래프가 된다.

・L1의 직선의 성질과 L2의 원의 성질은 실제로 다음 슬라이드와 같이 그려지며, 그로 부터 기인된 성질(다다음 슬라이드)을 가진다.

'C Lang > machine learing' 카테고리의 다른 글

| 8-5. sklearn Linear Model family (0) | 2019.05.06 |

|---|---|

| data processing, type of scalers (0) | 2019.05.06 |

| 8-3. Overfitting and regularization overview (0) | 2019.04.18 |

| 8-2. SGD implementation issues(convergence process, time-consuming, multivariate, learning rate decay, terminal condition setup) (0) | 2019.04.16 |

| 확률적 경사하강법의 이해 (1) | 2019.04.15 |